El cerebro humano es el procesador más poderoso de la naturaleza, por lo que no es sorprendente que el desarrollo de computadoras que lo imiten sea una meta a largo plazo de los científicos. Las redes neuronales, los sistemas de inteligencia artificial que aprenden de una manera muy humana, son los modelos más cercanos que tenemos, y ahora los científicos de Stanford han desarrollado una sinapsis artificial orgánica, acercándonos a conseguir que los computadores sean más eficientes.

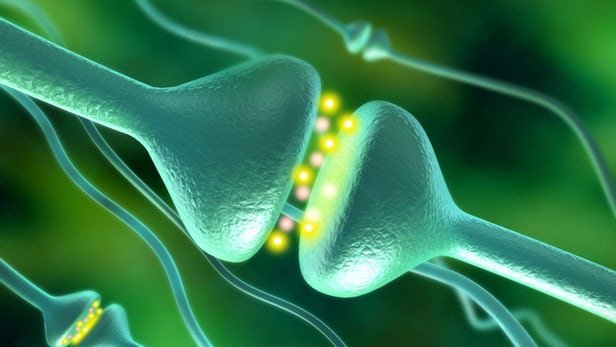

En un cerebro orgánico, las células neuronales envían señales eléctricas entre sí para procesar y almacenar información. Las neuronas están separadas por pequeños huecos llamados sinapsis, que permiten que las células pasen las señales entre sí, y cada vez que se hace el cruce, esa conexión se hace más fuerte, requiriendo menos energía cada vez. Ese fortalecimiento de una conexión es cómo el cerebro aprende, y el hecho de que el procesamiento de la información también lo almacena es lo que hace que el cerebro sea una máquina de aprendizaje tan poderosa.

Las redes neuronales modelan esto en un nivel de software. Estos sistemas de IA son excelentes para manejar enormes cantidades de datos, y al igual que el cerebro humano que los inspiró, cuanta más información reciben, mejor se desempeñan en su trabajo. Reconocimiento y clasificación de imágenes y sonidos son su principal área de especialización en este momento, y estos sistemas están conduciendo autos autónomos, superando a los mejores jugadores de GO de la humanidad, creando obras de arte extrañas e incluso enseñando a otras redes neuronales. El problema es que estos sistemas de software inteligente siguen funcionando con hardware de computadora tradicional, lo que significa que no son tan eficientes como podrían ser.

"Los algoritmos de aprendizaje profundo son muy potentes, pero dependen de los procesadores para calcular y simular los estados eléctricos y almacenarlos en otro lugar, lo que es ineficiente en términos de energía y tiempo", dijo Yoeri van de Burgt, autor principal del estudio. "En lugar de simular una red neuronal, nuestro trabajo está tratando de hacer una red neuronal".

Así que el equipo se puso a construir una sinapsis física, artificial que imita la real mediante el procesamiento y el almacenamiento de información simultáneamente. Basada en una batería y funcionando como un transistor, el dispositivo se compone de dos películas delgadas y tres terminales, con agua salada que actúa como un electrolito entre ellos. Las señales eléctricas saltan entre dos de las tres terminales a la vez, controlados por la tercera.

Primero, los investigadores entrenaron la sinapsis enviando varias señales eléctricas a través de ella, para averiguar qué voltaje se necesita aplicar para conseguir que cambie a cierto estado eléctrico. Los transistores digitales tienen dos estados - cero y uno - pero con su disposición de tres terminales, la sinapsis artificial es capaz de tener hasta 500 estados diferentes programados, expandiendo exponencialmente la potencia computacional de la que podría ser capaz.

Mejor aún, el cambio entre estados toma una fracción de la energía de otros sistemas. Eso todavía no está en el nivel de un cerebro - la sinapsis artificial usa 10.000 veces la energía de una biológica - pero es un paso en la dirección correcta, y con más pruebas en dispositivos más pequeños, los investigadores esperan mejorar eventualmente esa eficiencia.

"Cada vez más el tipo de tareas que esperamos que nuestros dispositivos de computación sean capaces de hacer requieren de computación que imita al cerebro, porque el uso de la informática tradicional para llevar a cabo estas tareas necesita de un consumo energético cada vez mayor", de acuerdo a A. Alec Talin, otro de los autores del estudio. "Hemos demostrado un dispositivo ideal capaz de ejecutar este tipo de algoritmos y que consume mucho menos energía".

Aunque sólo se ha construido una sinapsis artificial hasta ahora, el equipo realizó extensos experimentos sobre ella y extrapoló los datos reunidos para simular cómo una serie de sinapsis artificiales podría procesar información. Haciendo uso de las habilidades de reconocimiento visual de una red neuronal, los investigadores probaron su capacidad para identificar números escritos a mano - 0 a 9 - en tres estilos diferentes, y encontraron que el sistema podía reconocer los dígitos hasta el 97 por ciento del tiempo.

Ejemplos anteriores de sinapsis artificiales, como el de USC en 2011, no sólo eran menos potentes, sino que no estaban hechos completamente de materiales orgánicos. Compuesta en su mayor parte de hidrógeno y carbono y funcionando en los mismos voltages que las neuronas humanas, la sinapsis de Stanford podría integrarse con cerebros biológicos, abriendo la posibilidad de dispositivos que pueden ser controlados más directamente por el pensamiento, como las prótesis y las interfaces cerebro-máquina.

El siguiente paso para los investigadores es probar los resultados simulados mediante la producción de una matriz física de sinapsis artificiales.