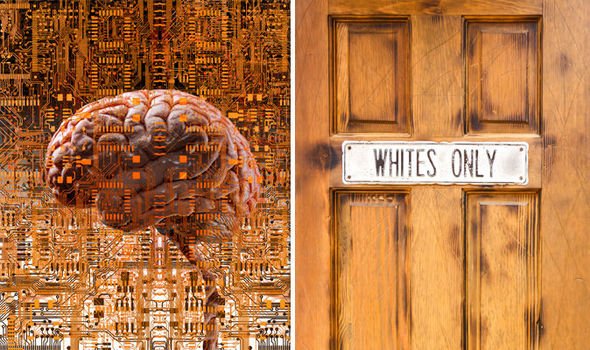

Es ist wahr, KI wird rassistisch, als es von Menschen lern! Roboter-Rassismus oder ein auf empirischen Daten basiertes Urteil?

Die express.co.uk -lesen sie den Artikel hier- schreibt:

Künstlich intelligente Software, die von der Polizei verwendet wurde, um Verdächtige zu identifizieren, ist rassistisch, nach einem Untersuchungsbericht.

In Teilen der USA, wenn ein Verdächtiger für die Befragung vernommen wird, erhalten sie eine computergesteuerte Risikobewertung, die die Wahrscheinlichkeit der Rehabilitation der Person ausarbeitet. Die Richter können diese Daten dann bei der Bewertung ihres Urteils verwenden. Eine Untersuchung hat jedoch Zeigte, dass die künstliche Intelligenz hinter der Software rassistische Tendenzen aufweist. [...]

[...] Dies ist nicht ein isolierter, einzelner Vorfall.

Microsoft's TayTweets (AI) Chatbot wurde auf Twitter im vergangenen Jahr entfesselt, die entworfen wurde, um von Benutzern zu lernen.

Allerdings wandte es sich fast sofort dem Antisemitismus und Rassismus zu, und begann zu tweeten: "Hitler hat nichts falsch gemacht" und "Hitler hatte recht - ich hasse die Juden".

Was denkt IHR über dieses Thema? Lasst doch einfach einen Kommentar da!!!

Sie finden uns auf: VK - Facebook - Google +

Weitere Informationen:

https://armageddonbroadcastnetwork.tv/

https://sanctuaryinterfaith.org/

https://mikdashhamoshiach.co.il/

http://torah-codes.net/

http://www.ra-el.org/

Spenden Sie uns @

1PEnaXMXfzFkJKQs5M4oaCoPoEKuMeNR3V

Keine neue Erkenntnis

Political correctness ist halt doch nur eine weitere Ideologie, geschaffen, um zu herrschen.

Im Brigen hat sich auch die Rassismusdefinition gewandelt hinzu einer moralischen Keule.

Downvoting a post can decrease pending rewards and make it less visible. Common reasons:

Submit

Die Geschichte von dem Microsoft Bot kenne ich, der Bot war öffentlich im Internet und man konnte mit ihm kommunizieren und ein paar Leute haben sich einen Spaß daraus gemacht ihm zum Rassisten zu trainieren.

Die Geschichte von der Polizei AI könnte zwei Ursachen haben, entweder sie wurde von wem auch immer so trainiert oder sie ist dazu geworden indem sie Kriminalitätsstatistiken ausgewertet hat und eine signifikante Häufung bei einer Personengruppe festgestellt hat.

Im ersten Fall müsste man darüber nachdenken wie und durch welche Einflüsse die AI trainiert wird. Im zweiten Fall, wenn der Computer also zurecht zu dieser Annahme kam, haben wir ein Problem mit political correctness. Dann sollte man sich Gedanken machen warum das so ist.

Downvoting a post can decrease pending rewards and make it less visible. Common reasons:

Submit

Ich denke, das Problem ist, das künstliche Intelligenz bisher keine Intelligenz ist, sondern nur ein von Menschen gemachtes Programm das bestimmten Parametern folgt.

Intelligenz wird es erst, wenn es - wie Menschen - "outside the box" denken kann. Das heißt zB., das es in Betracht zieht belogen zu werden. Intelligenz ist halt mehr als nur viele Daten optimal zu verknüpfen.

Downvoting a post can decrease pending rewards and make it less visible. Common reasons:

Submit

Computer sind unschuldig. :-)

Downvoting a post can decrease pending rewards and make it less visible. Common reasons:

Submit

Rassismus hat eine Grundlage? Wahrscheinlich ja, aber Rassismus soll keine Rechtfertigung für wirtschaftliche Ausbeutung liefern.

Downvoting a post can decrease pending rewards and make it less visible. Common reasons:

Submit

delete

Downvoting a post can decrease pending rewards and make it less visible. Common reasons:

Submit

This post has received a 7.95 % upvote from @buildawhale thanks to: @jeanviete.

Downvoting a post can decrease pending rewards and make it less visible. Common reasons:

Submit