최근 DeepSeek 추론 모델 R1 소식과 함께 엔비디아 주가가 하락하면서 많은 이들이 놀랐던 것 같습니다. DeepSeek는 DeepSeek-R1 뿐만 아니라 이미지 생성 모델 Janus도 공개하였습니다.

특히 주목할 만한 부분은 DeepSeek가 저비용(엔비디아의 저사양 그래픽카드 H8 활용)으로 언어 모델을 훈련하면서도 뛰어난 성능을 보인다는 것입니다. 그리고 미국 수학 경시대회에서 79.8%의 성과를 기록하여 ChatGPT를 능가했다고 합니다.

DeepSeek-R1

2025년 1월 20일, DeepSeek에서 DeepSeek-R1 추론 모델을 공개하였습니다.

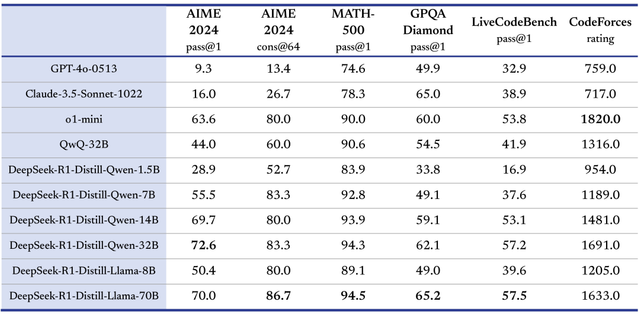

DeepSeek-R1은 DeepSeek의 첫 번째 추론 모델로, DeepSeek-R1의 모태가 되는 R1-Zero는 지도학습(SFT) 없이 대규모 강화학습(RL)만으로 학습하여 자연스러운 추론 능력을 획득했습니다. 이 모델은 수학, 코드, 논리 추론 등 여러 작업에서 OpenAI-o1과 유사한 성능을 달성하였습니다.

그리고 오픈소스로 DeepSeek-R1 양자화 모델(1.5B/7B/8B/14B/32B/70B)을 공개하였습니다. DeepSeek-R1 양자화 모델은 Ollama를 통해 다운로드하여 로컬에서 사용할 수 있습니다.

- Chat: https://chat.deepseek.com

- API: https://platform.deepseek.com/

- HuggingFace: https://huggingface.co/deepseek-ai/DeepSeek-R1

- PDF: https://github.com/deepseek-ai/DeepSeek-R1/blob/main/DeepSeek_R1.pdf

- Ollama: https://ollama.com/library/deepseek-r1

OpenAI SDK에서 DeepSeek R1 모델 사용하기

DeepSeek는 OpenAI API와 호환되는 deepseek-reasoner 모델을 제공합니다.

deepseek-reasoner는 DeepSeek이 개발한 추론 모델로, 최종 답변을 제공하기 전에 사고의 흐름(CoT, Chain of Thought)을 생성하여 답변의 정확성을 높이는 방식을 사용합니다. API를 통해 사용자는 deepseek-reasoner가 생성한 CoT 콘텐츠를 보고 활용할 수 있습니다.

# API 호출 예시

from openai import OpenAI

client = OpenAI(api_key="<KEY>", base_url="https://api.deepseek.com")

response = client.chat.completions.create(

model="deepseek-reasoner",

messages=[{"role": "user", "content": "9.11과 9.8 중 더 큰 숫자는?"}]

)

reasoning_content = response.choices[0].message.reasoning_content

content = response.choices[0].message.content

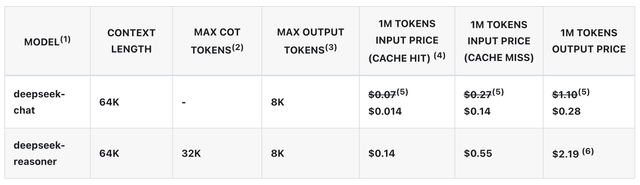

Deepseek R1 모델 가격

DeepSeek R1(deepseek-reasoner) API의 토큰 가격은 $0.55(입력) / $2.19(출력) per 1M tokens입니다.

R1이 정말로 OpenAI의 o1과 유사한 성능을 낸다면 가격적으로 경쟁력이 매우 높습니다. o1-min 토큰 가격과 비교해도 상대적으로 저렴합니다.

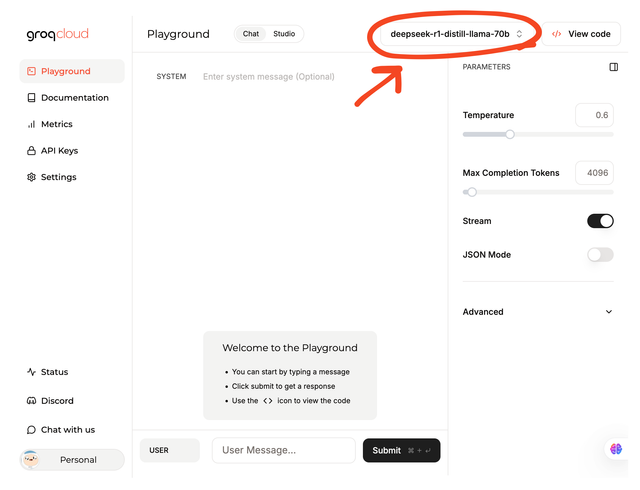

Groq Cloud에서 DeepSeek R1 모델 사용하기

Groq Cloud에서는 deepseek-r1-distill-llama-70b 모델을 을 무료 API로 제공합니다. Groq Cloud의 API를 활용하면 deepseek-r1-distill-llama-70b 모델을 무료로 사용할 수 있습니다.

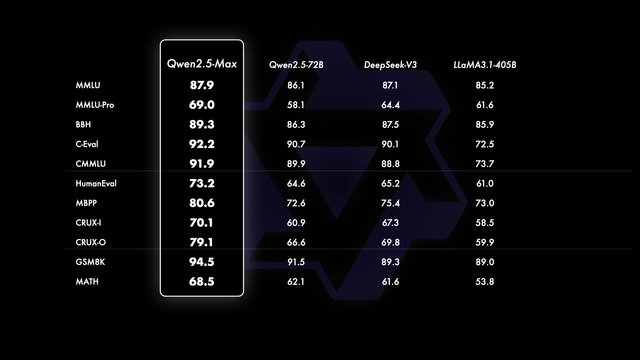

Qwen2.5-Max

2025년 1월 28일, Qwen도 Mixture-of-Expert (MoE) 모델 Qwen2.5-Max를 공개하였습니다.

- Qwen Chat: chat.qwenlm.ai

- API: Alibaba Cloud API

- 데모: HuggingFace

- Discord: Qwen 공식 채널

Qwen2.5-Max는 대규모 MoE(Mixture-of-Expert) 모델로, 20조 개 이상의 토큰으로 사전 학습되었으며, SFT와 RLHF 기법을 활용하여 추가 학습되었습니다. 이 모델은 MMLU-Pro, LiveCodeBench, LiveBench, Arena-Hard 등 다양한 벤치마크에서 DeepSeek V3와 같은 최신 모델들을 능가하는 성능을 보여주었다고 합니다.

Qwen2.5-Max는 Alibaba Cloud를 통해 API로 제공되며, Qwen Chat에서도 직접 사용할 수도 있습니다.

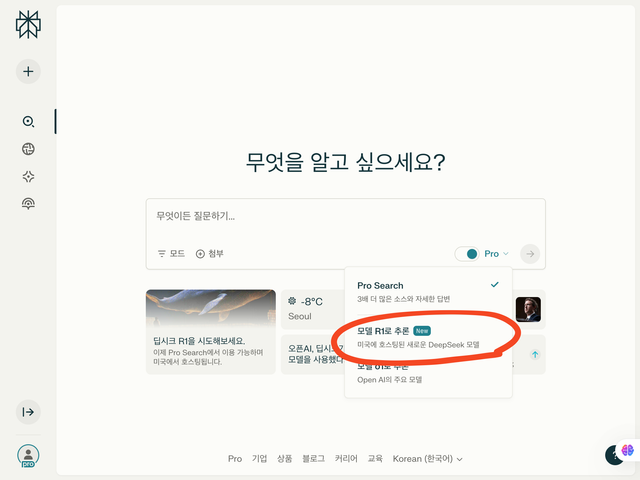

Perplexity에서 Deepseek R1 모델 사용하는 방법

이제 Perplexity에서도 DeepSeek R1 모델을 선택하여 사용할 수 있습니다.

Upvoted! Thank you for supporting witness @jswit.

Downvoting a post can decrease pending rewards and make it less visible. Common reasons:

Submit

Downvoting a post can decrease pending rewards and make it less visible. Common reasons:

Submit